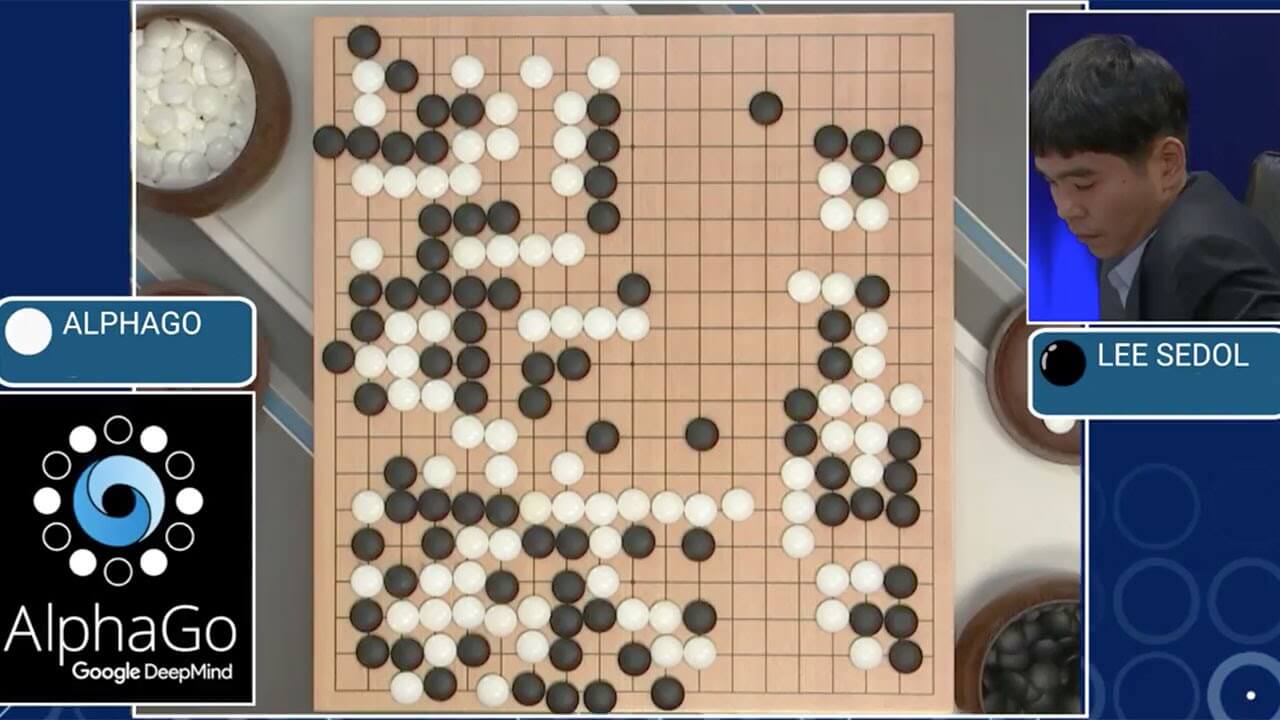

➤ Förra året vann AlphaGo , en Go-spelande artificiell intelligens (AI) från det Google-ägda DeepMind, en match mot den 18-faldiga världsmästaren Lee Se-dol från Sydkorea. Det sågs som ett stort steg framåt för AI då forskare trodde att det först skulle ske tio år fram i tiden. Men i år togs ytterligare ett stort steg: AI som lärde sig på egen hand.

Medan första generationen av AlphaGo lärde sig från århundraden av mänskliga strategier och spelsätt gjorde 2017 års version, AlphaGo Zero, något helt annat. AlphaGo Zero startade från noll och började med slumpmässiga drag och lärde sig genom att spela mot sig själv. 30 miljoner matcher och 40 dagar senare slog den självlärda AI:n den tidigare mästaren, AlphaGo Master. Jämförelsevis tog det föregångarna månader att lära upp sig.

Mer komplicerat än schack

AI-program har sedan länge kunnat besegra mänskliga spelare i spel såsom schack och dam genom att analysera varje möjligt drag som finns och räkna ut sannolikheten att det draget ska leda till vinst. Men denna sifferexcersis är inte möjlig i ett helt Go-spel eftersom det finns för många möjliga drag för dagens datorer att hantera: så många som 2,08 x 10^170, ett nummer som hamnar mellan en quinquavigintilliard och en trigintilliard, eller 208 följt av 168 nollor.

AI-program har sedan länge kunnat besegra mänskliga spelare i spel såsom schack och dam genom att analysera varje möjligt drag som finns och räkna ut sannolikheten att det draget ska leda till vinst. Men denna sifferexcersis är inte möjlig i ett helt Go-spel eftersom det finns för många möjliga drag för dagens datorer att hantera: så många som 2,08 x 10^170, ett nummer som hamnar mellan en quinquavigintilliard och en trigintilliard, eller 208 följt av 168 nollor.

“Inget annat än fantastiskt”

Denna teknik, som kallas “reinforcement learning”, är svår att få att fungera bra och dessutom resursintensivt, menar Oren Etzioni, VD för Allen Institute for Artificial Intelligence i Seattle, Washington. Att en sådan algoritm har kunnat göras som överträffade tidigare versioner med mindre tid och datorkraft är “inget annat än fantastiskt”, anser han.

Praktisk användning

Flera av forskarna från Deepmind har redan börjat titta på liknande teknik för praktiska applikationer såsom exempelvis hur proteiner veckar sig, den process genom vilken ett protein får sin specifika tredimensionella form, vilket är en avgörande faktor för nya mediciner. I ett längre perspektiv kan sådana algoritmer användas inom kvantkemi, materialdesign och robotik.

Dock måste AI:n ha förmågan att lära sig från mindre data och dessutom lära sig reglerna själv, vilket en annan DeepMind-algoritm lyckades med 2015. DeepMinds VD Demis Hassabis tror att detta är något AlphaGo Zero kan göra till slut. “Vi är rätt säkra på att det går att göra, men det ökar inlärningsperioden mycket”, tror han.